【Swift UI/AVFoundation】カメラアプリを開発する方法!撮影と保存

この記事からわかること

- Swift UIでカメラアプリの実装方法

- AVFoundationの使い方や特徴

- カスタマイズできるカメラビューの作り方

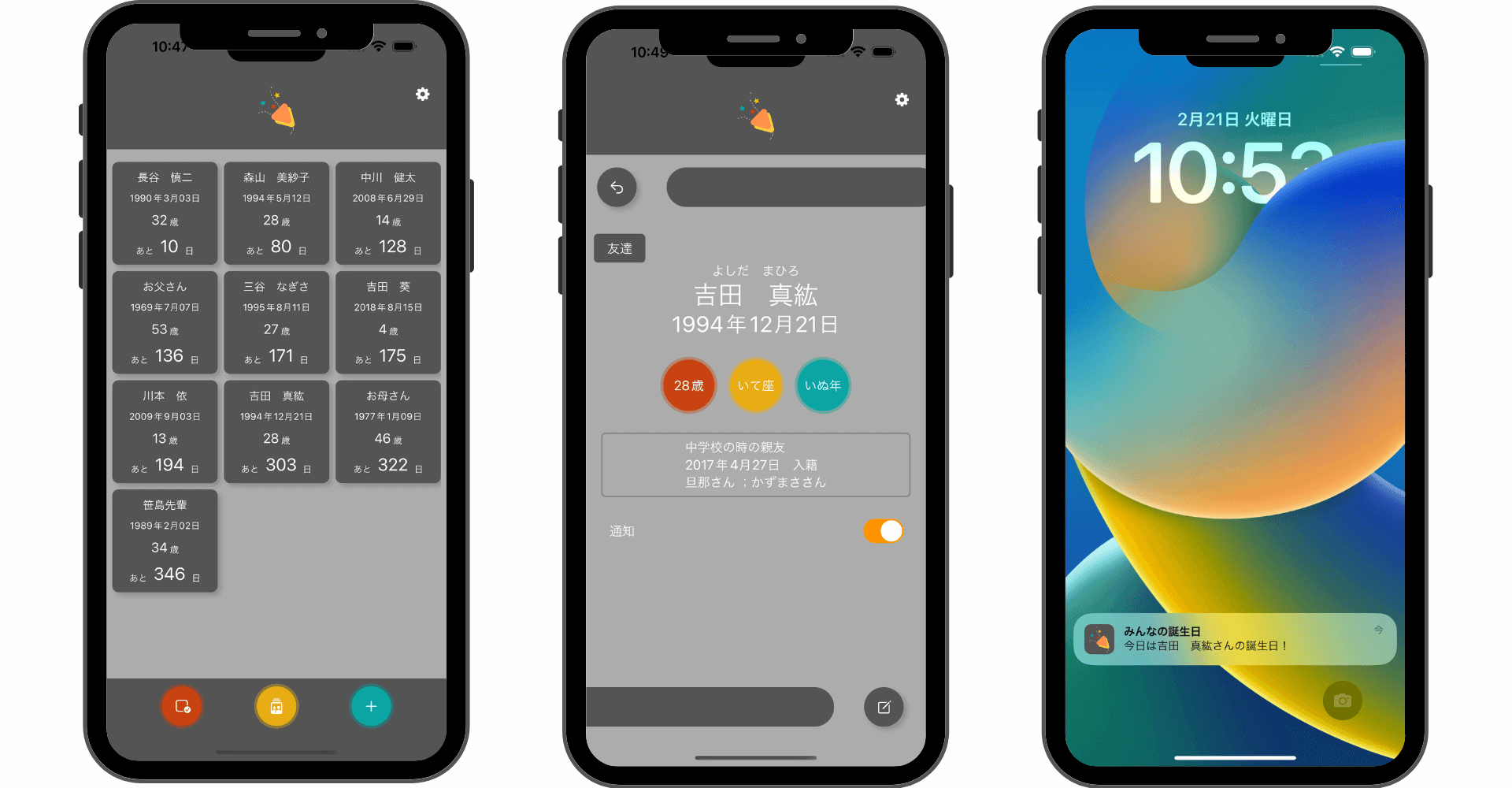

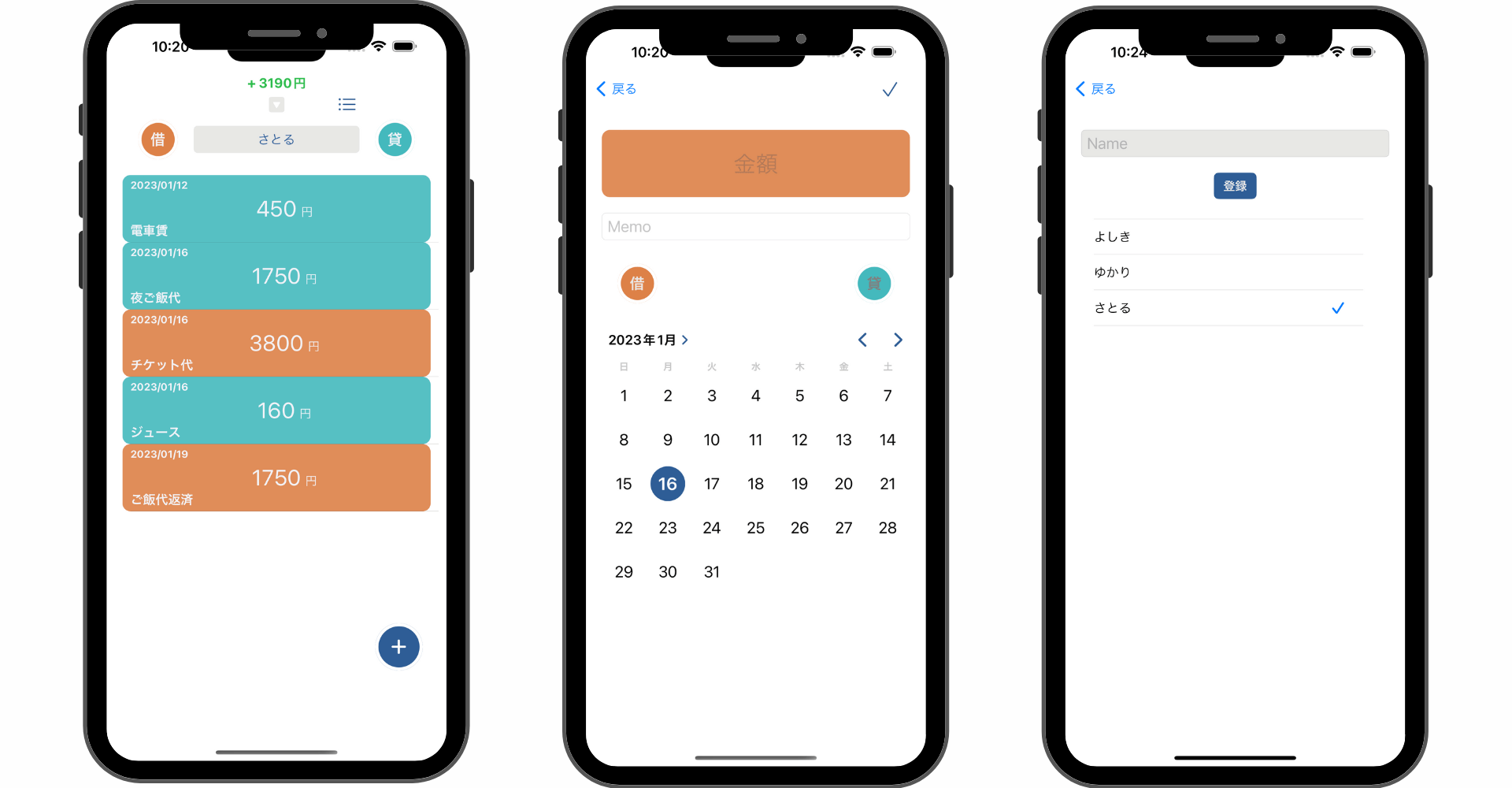

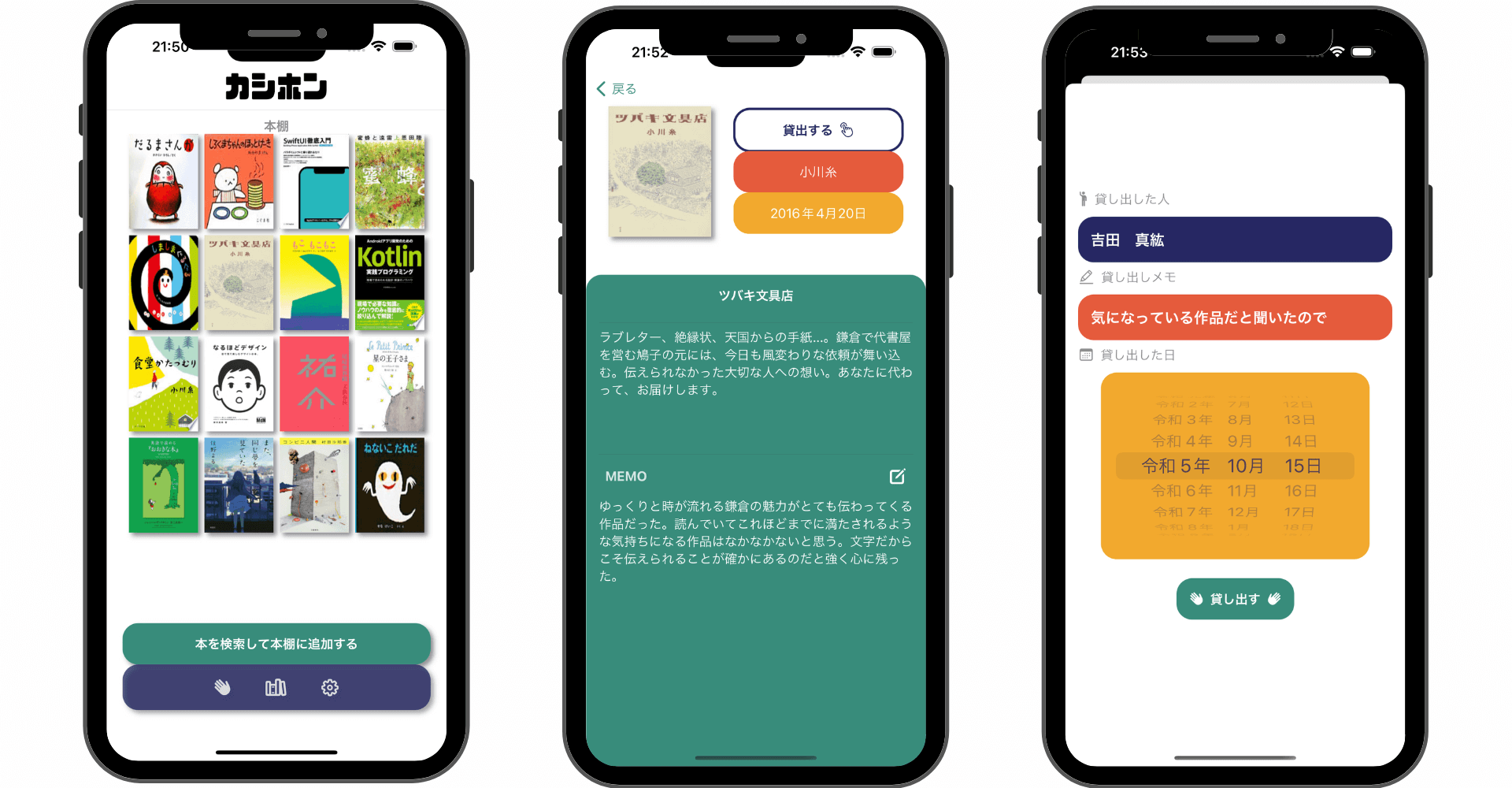

\ アプリをリリースしました /

環境

- Xcode:15.0.1

- iOS:17.0

- Swift:5.9

- macOS:Sonoma 14.1

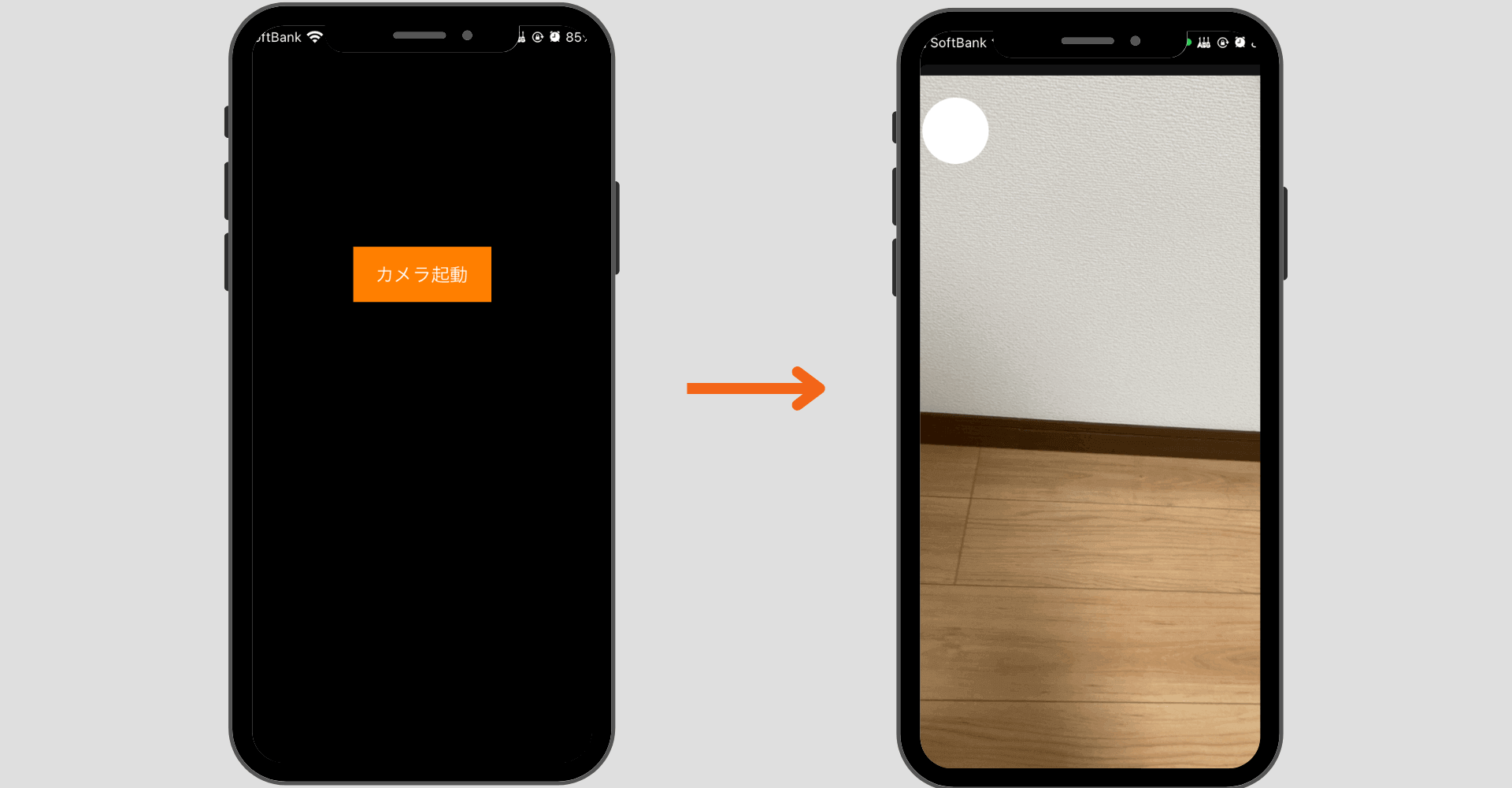

Swift UIでカメラアプリを実装したい場合はUIImagePickerControllerをSwift UIで表示できるようにしたり、AVFoundationを駆使して実装する必要があります。今回はAVFoundationを使用してSwift UIでカメラアプリを作ってみたいと思います。

AVFoundationとは?

AVFoundationは実装するのはなかなか手間がかかりますがカスタマイズ性が高く柔軟なカメラアプリを開発することができるフレームワークで、撮影ボタンの位置やデザイン、カメラビューのサイズなどを好きなように配置できるので独自のカメラアプリを作成するのにおすすめです。

AVFoundationの基本的な使い方はUIKitでの実装方法とともに以下の記事で紹介しているので今回はSwift UIで実装する方法をまとめていきます。

Swift UIでAVFoundationを使用する方法

Swift UIでAVFoundationを使用するためには以下の3ファイルを用意します。ファイルの構成のアドバイスがあればお願いします。

作成するファイル

- Viewファイル

- ViewModelファイル

- Repositoryファイル

全体像はGitHubに上げているので参考にしてください。

おすすめ記事:GitHub-MyCameraApp

Repositoryファイル

ViewModelファイル

Viewファイル

まだまだ勉強中ですので間違っている点や至らぬ点がありましたら教えていただけると助かります。

ご覧いただきありがとうございました。